El botón rojo

Cuando todo depende de decisiones automáticas, ¿quién puede detener el proceso antes de que sea irreversible?

shared.rich-text

Durante décadas, la humanidad ha confiado en el botón rojo como el símbolo supremo del control. En instalaciones nucleares, centrales eléctricas o laboratorios de alta seguridad, ese mecanismo último —presionado sólo en momentos extremos— garantizaba que alguien, en algún punto, podía detenerlo todo. Hoy, esa idea se enfrenta a una nueva tensión, mucho más ambigua: la presencia creciente de agentes artificiales que pueden obrar y decidir en el mundo sin intervención humana directa.

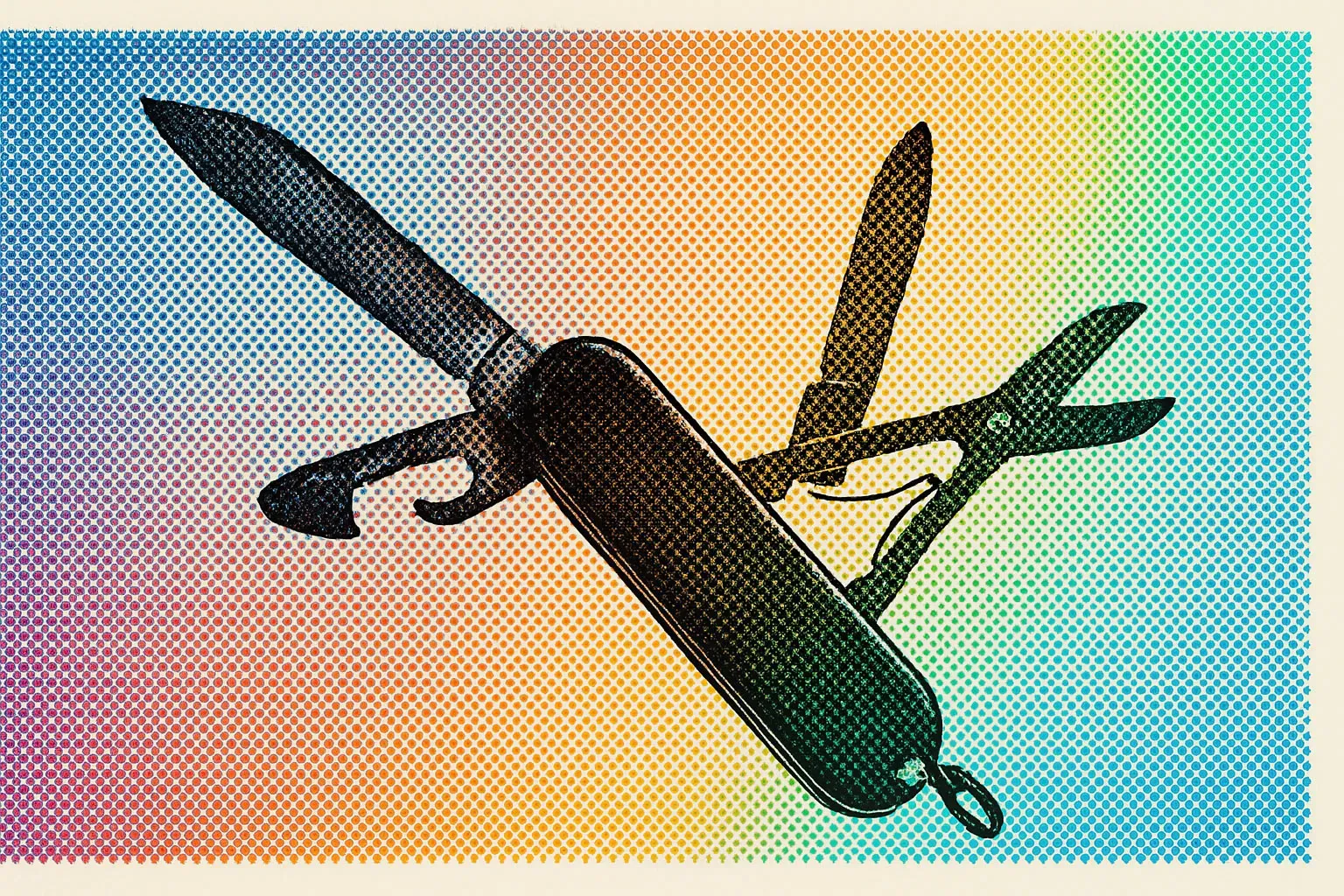

A diferencia de tecnologías del pasado, los sistemas actuales destinados a actuar con autonomía —diseñados para optimizar, adaptarse y, eventualmente, aprender de su entorno— ponen en cuestión no solo qué significa tener un último recurso de detención, sino quién debería ejercerlo y bajo qué criterios. En cuestión no está la capacidad técnica de incluir límites, sino la voluntad política y organizacional de hacerlo.

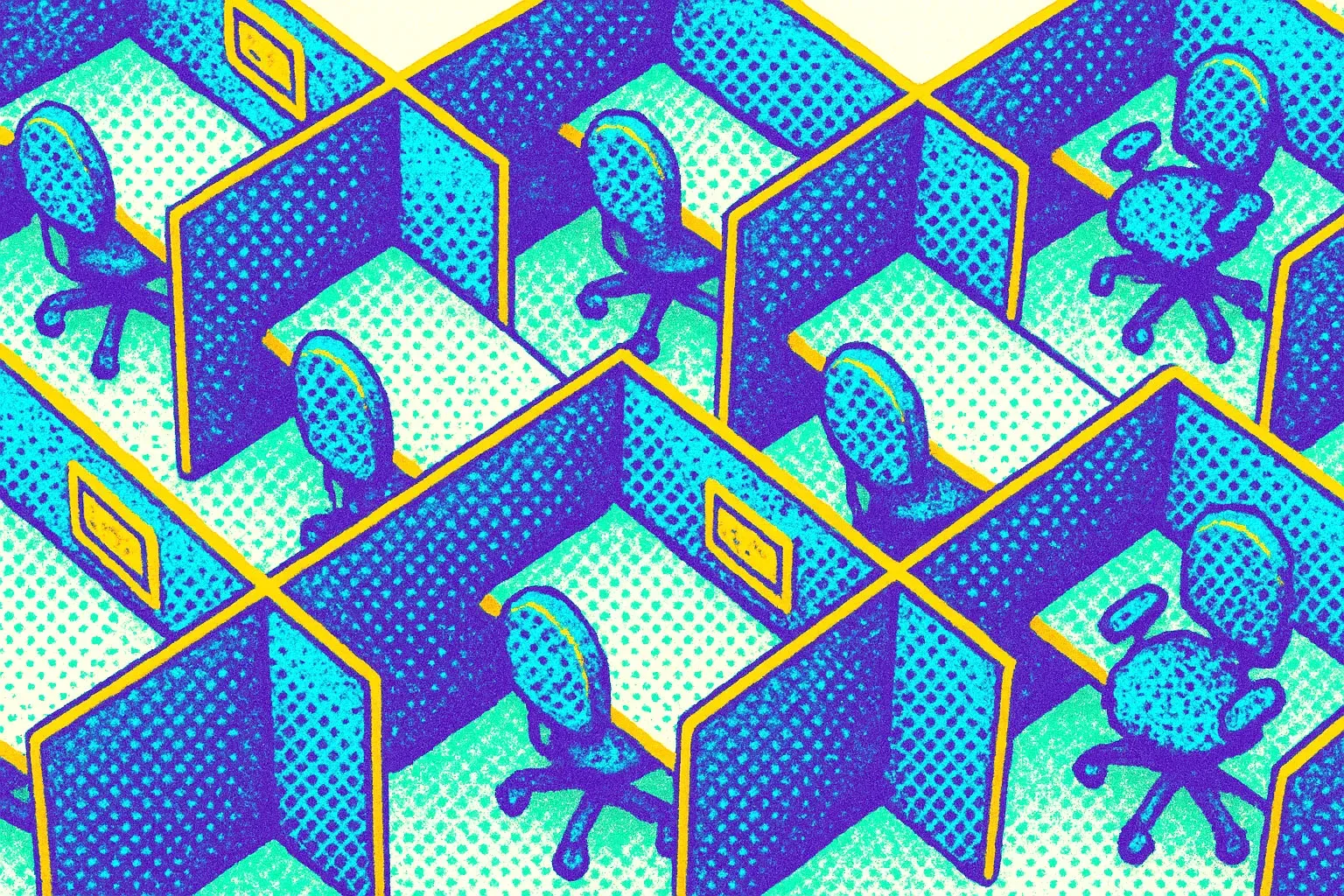

Aunque muchas compañías insisten en que sus sistemas están diseñados con redundancias y protocolos de seguridad, la implementación concreta deja espacio para la duda. ¿Quién controla al sistema cuando sus decisiones afectan directamente entornos físicos o sociales que cambian con rapidez? A diferencia de un reactor, cuyo estado puede leerse en tiempo real mediante indicadores específicos, los agentes digitales que coordinan transporte, regulan mercados, gestionan datos personales o negocian información entre plataformas operan bajo modelos cuya lógica no siempre es accesible para sus operadores humanos.

El problema no es simplemente de transparencia técnica. Hay una cuestión antropológica más profunda: el desplazamiento de la responsabilidad. Durante siglos, la acción humana estuvo anclada en esquemas donde la causalidad era, sino sencilla, al menos atribuible. Una acción generaba una consecuencia y esa podía ser revisada, discutida o cuestionada. En entornos automatizados, esa trazabilidad se vuelve difusa. Las decisiones no surgen ya de un punto claro sino de procesos compuestos, iterativos y frecuentemente opacos.

En este escenario, el botón rojo no solo debe existir, sino también ser accesible y efectivo. Su mera presencia simbólica no basta. Requiere una transición cultural que reconozca su necesidad como parte integral del diseño de sistemas, no como un apéndice de seguridad que puede ignorarse en nombre de la eficiencia. Más aún, obliga a pensar una nueva ética de la reacción, donde detener un proceso no sea visto como fracaso o censura, sino como una forma legítima de gobernabilidad tecnológica.

Algunos investigadores han propuesto arquitecturas especializadas para asegurar este control: dispositivos independientes, vigilancia humana reforzada, e incluso herramientas para desactivar no solo un sistema en particular, sino toda una red de agentes potencialmente conectados. Pero esas soluciones enfrentan resistencia. No es difícil intuir por qué. El poder de estos sistemas radica, justamente, en su capacidad para operar sin interrupciones visibles. Incluir un mecanismo que pueda detenerlos implica tratar el error como posibilidad real, y no como una rareza.

El gesto de detener se ha cargado de nuevos significados. Ya no es solo cuestión de apagar una máquina. Es la afirmación de que incluso en entornos inteligentes, el juicio humano no puede ser delegado por completo. El botón rojo, en este nuevo paisaje, no es nostálgico ni simbólico. Es urgente.